Google I/O 2025 ปีนี้ มาในธีมจากห้องวิจัยสู่ความเป็นจริง ที่ดึงงาน AI ออกมาให้ใช้งานได้จริง จึงมีการโชว์ฟีเจอร์ AI ใหม่ๆ แบบจัดเต็ม ทั้งเป็นการอัปเกรดของเก่าให้ดีกว่าเดิม และเปิดตัวฟีเจอร์ใหม่ๆ ให้ได้ใช้งาน จัดหนักจัดเต็มกว่าเดิม ทั้งเพื่อนักพัฒนาและผู้ใช้งานทั่วไป แต่จะมีอะไรน่าสนใจบ้างในปีนี้ แล้วปีนี้เราจะได้ยินคำว่า AI กี่คำ เราจะมารวมสรุปให้อ่านกันในบล็อกนี้เลย

ดูไลฟ์ Google I/O 2025 พากย์ไทย

Google อวด คนใช้งาน AI มากขึ้น

มาเริ่มที่ Google เผยสถิติที่สะท้อนการเติบโตของ AI จากจำนวนการใช้งาน

- จำนวนโทเคนที่ประมวลผลต่อเดือนเพิ่มขึ้น 50 เท่า — จาก 9.7 ล้านล้านโทเคน เป็นกว่า 480 ล้านล้านโทเคน

- นักพัฒนาใช้งาน Gemini เพิ่มขึ้น 5 เท่า เป็นกว่า 7 ล้านคน

- การใช้งาน Gemini บน Vertex AI เพิ่มขึ้น 40 เท่า

- ผู้ใช้ Gemini App มากกว่า 400 ล้านคนต่อเดือน โดยเฉพาะผู้ใช้ Gemini 2.5 Pro มีอัตราการใช้งานเพิ่มขึ้นถึง 45%

ทั้งหมดนี้ชี้ให้เห็นว่าทั่วโลกกำลังปรับตัวและนำ AI เข้ามาใช้ในชีวิตประจำวันมากกว่าที่เคยเป็นมา

จากการวิจัยสู่ความเป็นจริง ธีมงานหลักของปีนี้

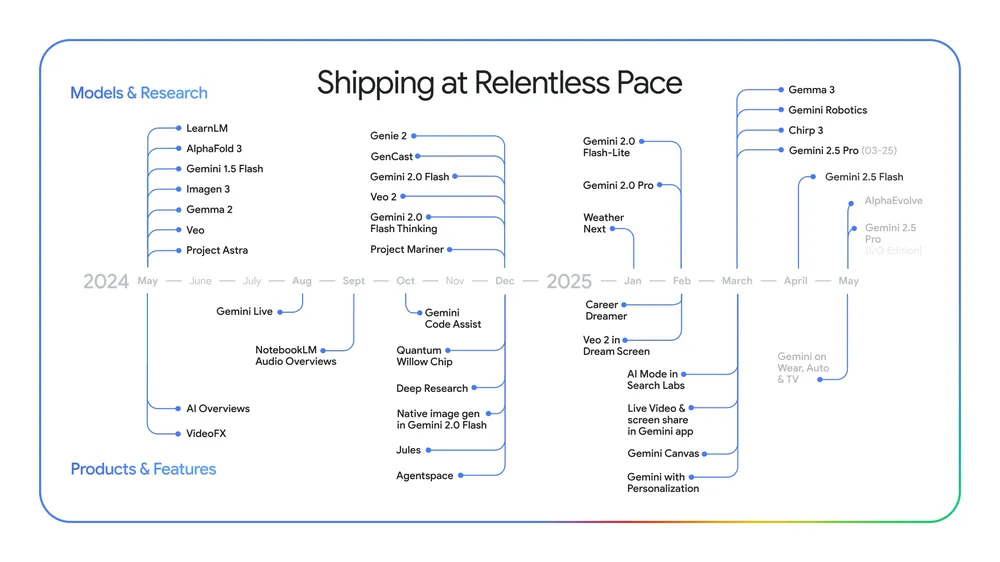

โดยจากภาพด้านบน จะเป็นภาพ ไทม์ไลน์การเปิดตัวผลิตภัณฑ์และงานวิจัยของ Google ภายใต้หัวข้อ “Shipping at Relentless Pace” ซึ่งแสดงให้เห็นว่า Google เดินหน้าพัฒนาและเปิดตัวนวัตกรรมใหม่ ๆ อย่างต่อเนื่อง ตั้งแต่ พฤษภาคม 2024 ถึงพฤษภาคม 2025 โดยแบ่งเป็น 2 หัวข้อ Models & Research (โมเดลและงานวิจัย) และ Products & Features (ผลิตภัณฑ์และฟีเจอร์)

จาก Project Starline สู่ Google Beam + การแปลเสียงพูด

Google Beam

หนึ่งในไฮไลต์สำคัญของงานนี้คือการเปิดตัว Google Beam ซึ่งเป็นการพัฒนาต่อจาก Project Starline ที่เคยสร้างความฮือฮาด้วยการสนทนาแบบ 3 มิติ

Google Beam ใช้กล้อง 6 ตัว ร่วมกับ AI เพื่อรวมวิดีโอ 2D ให้กลายเป็นประสบการณ์การสนทนา 3 มิติแบบเรียลไทม์ ด้วยระบบ head tracking ความแม่นยำระดับมิลลิเมตรและเฟรมเรต 60 fps บนจอแสดงผล lightfield 3D แบบล้ำสมัย

Google ร่วมมือกับ HP เพื่อพัฒนาอุปกรณ์ Beam และเตรียมเปิดให้ลูกค้ารายแรกใช้งานได้ภายในปีนี้

AI แปลเสียงแบบเรียลไทม์ บน Google Meet

ตลอดหลายปีที่ผ่านมา Google ได้พัฒนา Google Meet ให้กลายเป็นแพลตฟอร์มการประชุมที่สมจริงและเป็นธรรมชาติมากขึ้นเรื่อย ๆ ล่าสุด ได้เพิ่มเทคโนโลยีใหม่ที่ช่วยลดช่องว่างทางภาษา ด้วยการแปลเสียงพูดแบบเรียลไทม์

การแปลเสียงแบบเรียลไทม์: สมจริงทั้งเสียงและอารมณ์

- แปลคำพูดแบบทันที ขณะประชุม

- จับน้ำเสียงและโทนเสียงของผู้พูด ได้อย่างแม่นยำ

- แม้แต่การแสดงออกทางสีหน้า ก็ถูกนำมาประมวลผลให้การสนทนาดู “เป็นธรรมชาติ” มากขึ้น

- เป้าหมายคือการทำให้การสนทนา ข้ามภาษาเป็นเรื่องลื่นไหล ราวกับพูดคุยภาษาเดียวกัน

- ฟีเจอร์นี้เริ่มให้บริการแบบ เบต้า (ทดสอบ) แล้ว

- รองรับ ภาษาอังกฤษและสเปน

- สำหรับผู้ใช้งานแพ็กเกจ Google AI Pro และ Ultra

- วางแผนขยายการรองรับภาษาเพิ่มเติม ในอีกไม่กี่สัปดาห์ข้างหน้า

- ลูกค้าธุรกิจที่ใช้ Google Workspace จะสามารถทดลองใช้ฟีเจอร์นี้ได้ภายในปีนี้เช่นกัน

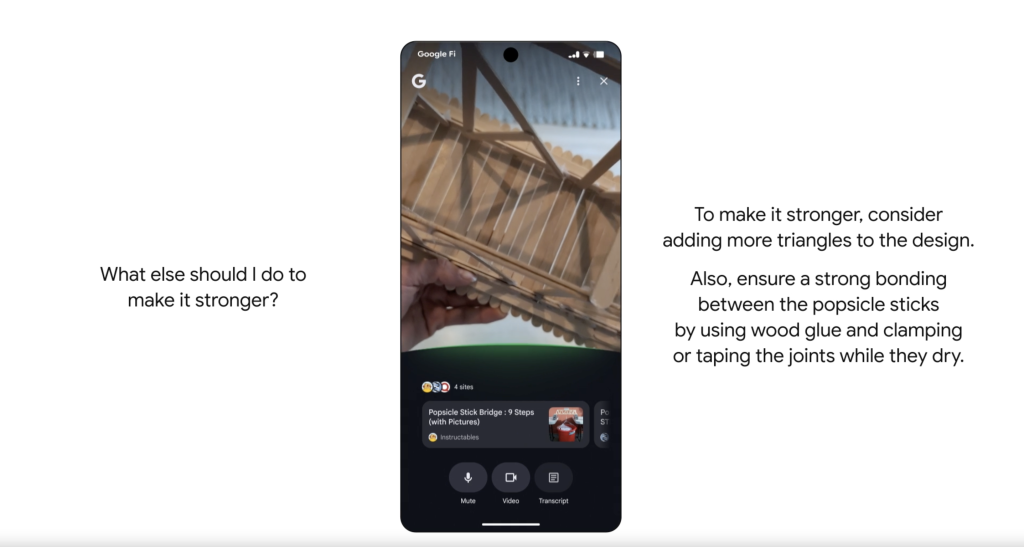

จาก Project Astra สู่ Gemini Live: ผู้ช่วยอัจฉริยะที่เข้าใจโลกจริง

หนึ่งในโครงการวิจัยสุดล้ำที่ Google เคยเปิดตัวในงาน I/O คือ Project Astra ซึ่งมีเป้าหมายในการสร้าง ผู้ช่วย AI อัจฉริยะที่สามารถเข้าใจสภาพแวดล้อมรอบตัวคุณได้จริง ไม่ใช่แค่ตอบคำถาม แต่เข้าใจ “โลกจริง” ผ่านกล้องและหน้าจอ

วันนี้ Project Astra ได้ถูกรวมเข้าเป็นส่วนหนึ่งของ Gemini Live แล้ว ฟีเจอร์ที่ให้ผู้ใช้งานสามารถ แชร์กล้องหรือหน้าจอมือถือ ให้ Gemini ช่วยดู วิเคราะห์ และโต้ตอบได้แบบเรียลไทม์

ตัวอย่างการใช้งานที่เกิดขึ้นจริง:

- ใช้ช่วยเตรียมตัวสัมภาษณ์งาน

- ใช้ประกอบแผนการฝึกซ้อมวิ่งมาราธอน

- หรือแม้แต่ขอคำแนะนำขณะทำสิ่งต่าง ๆ โดยให้ AI “มองเห็น” สิ่งที่ผู้ใช้เห็น

ความพร้อมใช้งาน:

- ผู้ใช้ Android ใช้งานฟีเจอร์นี้ได้แล้วทั่วโลก

- สำหรับ iOS เริ่มทยอยเปิดให้ใช้ตั้งแต่วันนี้เป็นต้นไป

นอกจากนี้ Google ยังเตรียมนำความสามารถนี้ไปต่อยอดสู่ผลิตภัณฑ์อื่น ๆ เช่น Google Search อีกด้วย

จาก Project Mariner สู่ Agent Mode : เมื่อ AI ช่วยทำงานแทนคุณได้จริง

Google กำลังพัฒนา AI ให้ก้าวไปอีกขั้น — ไม่ใช่แค่ตอบคำถาม แต่ สามารถ “ลงมือทำ” งานแทนได้จริง ผ่านสิ่งที่เรียกว่า “Agent” หรือ “ตัวช่วยอัจฉริยะ” ที่รวมความสามารถของโมเดล AI เข้ากับการเข้าถึงเครื่องมือออนไลน์ต่าง ๆ เพื่อดำเนินการตามคำสั่งของผู้ใช้ภายใต้การควบคุม

Project Mariner: ก้าวแรกสู่ AI ที่ใช้งานคอมพิวเตอร์แทนได้

Google เริ่มต้นด้วย Project Mariner ซึ่งเป็นต้นแบบของระบบ agent ที่สามารถใช้งานคอมพิวเตอร์และอินเทอร์เน็ตแทนผู้ใช้ เช่น กรอกแบบฟอร์ม ค้นหาข้อมูล หรือจัดการงานต่าง ๆ

สิ่งที่พัฒนาเพิ่มเติมคือฟีเจอร์:

- Multitasking: ทำหลายอย่างพร้อมกันได้

- Teach and Repeat: สอนให้มันทำงานหนึ่งครั้ง และมันจะจดจำเพื่อนำไปทำงานลักษณะเดียวกันในอนาคต

นักพัฒนาเริ่มใช้งานความสามารถของ Project Mariner ได้แล้วผ่าน Gemini API โดยมีพาร์ทเนอร์รายแรกอย่าง Automation Anywhere และ UiPath ที่เริ่มนำไปใช้จริง และจะเปิดให้ใช้งานกว้างขึ้นในช่วงฤดูร้อนนี้

สู่การสร้างระบบนิเวศของ AI Agents

Google ยังวางรากฐานเพื่อให้ระบบ agent สามารถทำงานร่วมกันได้ในวงกว้าง เช่น:

- Agent2Agent Protocol: ให้ agent หลายตัวคุยกันและประสานงานได้

- Model Context Protocol (MCP) จาก Anthropic: ให้ agent เข้าถึงบริการอื่น ๆ ได้ผ่านมาตรฐานร่วม

และตอนนี้ Gemini API และ SDK ของ Google ก็สามารถทำงานร่วมกับ MCP ได้แล้ว

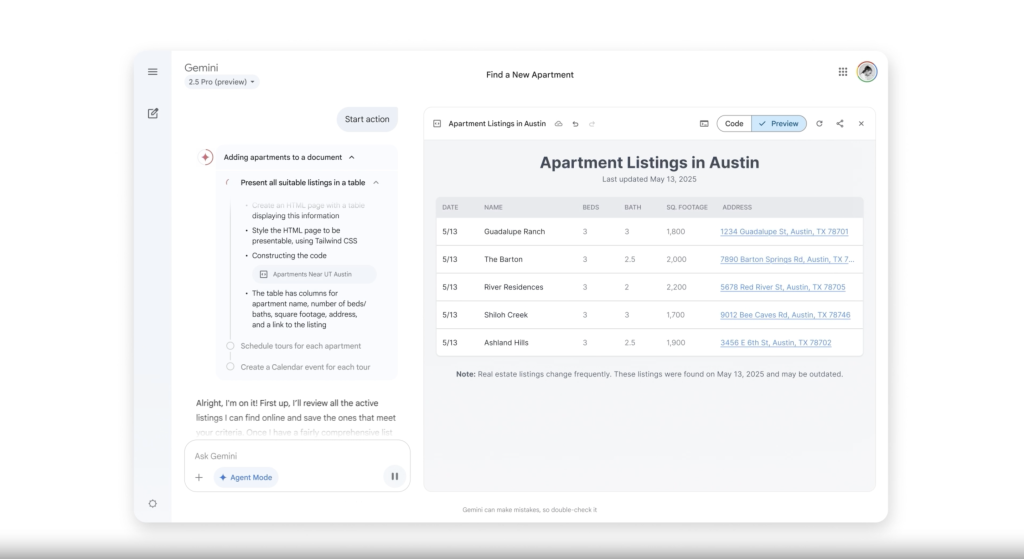

Agent Mode: โหมดใหม่ในแอป Gemini

Google เตรียมเปิดใช้งาน Agent Mode ในแอป Gemini ซึ่งจะเป็นผู้ช่วย AI ที่ทำงานให้คุณได้จริง เช่น หากคุณกำลังหาห้องพัก Agent Mode จะช่วย

- ค้นหาห้องตามเงื่อนไขในเว็บอย่าง Zillow

- ปรับตัวกรองการค้นหา

- ใช้ MCP เข้าถึงรายละเอียดห้อง

- และแม้แต่ นัดดูห้องให้คุณได้อัตโนมัติ

Agent Mode เวอร์ชันทดลองจะเปิดให้ผู้ใช้แบบสมัครสมาชิกในเร็ว ๆ นี้

พลังของความเป็นส่วนตัว : AI ที่รู้จักเราจริง ๆ

Google เชื่อว่าการนำงานวิจัยมาสู่ความเป็นจริงได้ดีที่สุด คือการทำให้ “มีประโยชน์ในชีวิตจริงของคุณเอง” ซึ่งจุดสำคัญของเรื่องนี้ก็คือ “การปรับให้เหมาะกับแต่ละคน” (personalization)

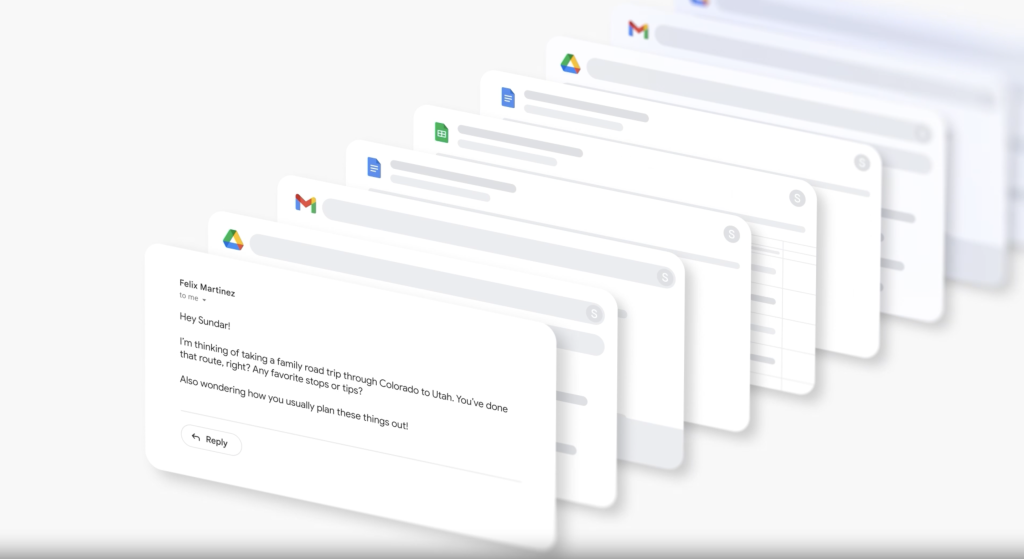

Personal Context : AI ที่เข้าใจคุณเป็นรายบุคคล

Google กำลังพัฒนาแนวคิดใหม่ที่เรียกว่า Personal Context หรือ “บริบทส่วนตัว” ที่จะให้ Gemini สามารถใช้ข้อมูลที่เกี่ยวข้องจากแอป Google ของตัวเรา เช่น Gmail, Docs, Drive ฯลฯ — แต่จะทำภายใต้ความเป็นส่วนตัว โปร่งใส และอยู่ภายใต้การควบคุมของเราทั้งหมด

ตัวอย่างการใช้งาน: Smart Reply ที่ตอบแทนเรา แบบ ‘ตัวเราจริง ๆ’

สมมติว่าเพื่อนส่งอีเมลมาขอคำแนะนำเรื่องทริปท่องเที่ยวที่เราเคยไปมา

- Gemini จะสามารถค้นหาไฟล์ที่เกี่ยวข้องใน Google Drive หรือ Gmail ของเรา เช่น ตารางทริปที่เคยจัดไว้ใน Google Docs

- แล้วนำมาใช้สร้าง ข้อความตอบกลับอัตโนมัติ (Smart Reply) ที่มีรายละเอียดจริง ตรงประเด็น

- ที่สำคัญ มันจะ ลอกลายสำนวนของเรา ทั้งน้ำเสียง สไตล์การพูด และแม้แต่คำศัพท์ที่ชอบใช้ ให้เหมือนเราเขียนเองจริง ๆ

ฟีเจอร์นี้จะเปิดให้ใช้งานกับผู้สมัครสมาชิกภายในปีนี้

มากกว่าการตอบอีเมล : พลังของบริบทส่วนตัว

แนวคิด “บริบทส่วนตัว” นี้จะไม่จำกัดแค่ Gmail แต่ยังจะถูกนำไปใช้กับบริการอื่นของ Google อย่าง Search, แอป Gemini และอีกมากมาย เพื่อให้ AI สามารถช่วยเหลือเราได้ลึกซึ้ง เป็นธรรมชาติ และตรงความต้องการส่วนตัวมากยิ่งขึ้น

AI Mode ใน Google Search : ยกระดับการค้นหาด้วยพลังของ Gemini

Google กำลังเปลี่ยนโฉมการค้นหาบนอินเทอร์เน็ต ด้วยการนำโมเดล AI อย่าง Gemini มาช่วยให้ Search ฉลาดขึ้น เป็นผู้ช่วยที่ลงมือทำได้ (agentic) และเข้าใจผู้ใช้ในแบบเฉพาะบุคคลมากขึ้น

AI Overviews : ความสำเร็จระดับโลก

ตั้งแต่เปิดตัวเมื่อปีที่ผ่านมา AI Overviews หรือสรุปคำตอบด้วย AI ได้กลายเป็นหนึ่งในฟีเจอร์ที่ประสบความสำเร็จมากที่สุดของ Search ในรอบ 10 ปี โดย:

- ขยายการให้บริการไปยัง กว่า 200 ประเทศและเขตพื้นที่

- มีผู้ใช้งานแล้วมากกว่า 1.5 พันล้านคน

- ในตลาดใหญ่ เช่น สหรัฐฯ และอินเดีย AI Overviews ช่วยเพิ่มการค้นหาประเภทใหม่ ๆ ขึ้นกว่า 10% และยังคงเติบโตต่อเนื่อง

- ผลลัพธ์ที่ได้คือ ผู้ใช้พึงพอใจกับคำตอบมากขึ้น และใช้ Search บ่อยขึ้น

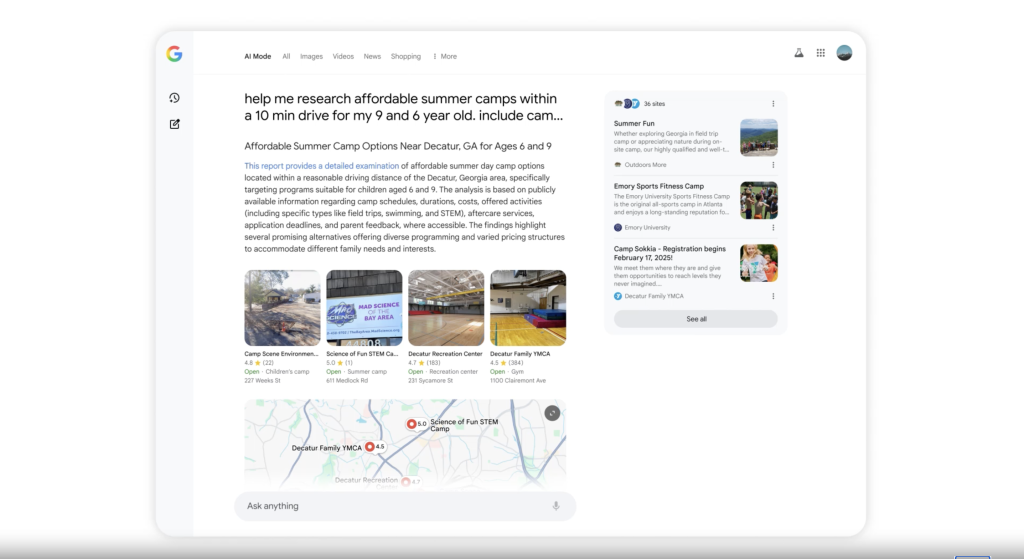

AI Mode : ประสบการณ์ค้นหาแบบใหม่จากต้นจนจบ

สำหรับผู้ที่ต้องการประสบการณ์การค้นหาที่ขับเคลื่อนด้วย AI แบบเต็มรูปแบบ Google เปิดตัว AI Mode โหมดใหม่ที่ “คิดใหม่หมด” สำหรับการค้นหาบนเว็บ

- รองรับคำค้นหาที่ยาวขึ้นและซับซ้อนมากขึ้น

- ผู้ทดสอบใช้งานจริงพิมพ์คำค้นที่ยาวกว่าการค้นหาแบบเดิมถึง 2–3 เท่า

- รองรับการ ถามต่อเนื่อง (follow-up) ได้ทันทีในหน้าเดิม

- เข้าถึงง่าย ๆ ผ่านแท็บใหม่ในหน้า Google Search

Sundar Pichai (CEO ของ Google) ยังบอกด้วยว่าเขาใช้งาน AI Mode เป็นประจำ และมันเปลี่ยนวิธีที่เขาใช้ Google ไปโดยสิ้นเชิง

พร้อมใช้งานแล้วในสหรัฐฯ พร้อม Gemini 2.5

เริ่มตั้งแต่วันนี้ AI Mode จะเปิดให้ผู้ใช้งานในสหรัฐฯ ทุกคน สามารถใช้ได้ทันที โดยรองรับด้วยโมเดลล่าสุดอย่าง Gemini 2.5 ที่ให้คุณภาพและความแม่นยำในระดับเดียวกับที่คนคาดหวังจาก Google Search และยังเป็น AI ที่ตอบเร็วที่สุดในอุตสาหกรรม ณ ขณะนี้

Search Live ค้นหาด้วยภาพแบบสด ๆ พร้อมพูดคุยกับ AI ได้แบบเรียลไทม์

Google ยกระดับการค้นหาด้วยภาพ (Visual Search) ให้ก้าวหน้าไปอีกขั้น หลังจากที่ผู้คนกว่า 1.5 พันล้านคนใช้ Google Lens ทุกเดือน เพื่อค้นหาสิ่งที่เห็นด้วยกล้อง

วันนี้ Google นำเทคโนโลยี “Live capabilities” จาก Project Astra เข้ามาสู่ Search เปิดตัวเป็นฟีเจอร์ใหม่ชื่อว่า Search Live ที่ “เห็น” พร้อมพูดคุยกับเรา

- ใช้กล้องมือถือ ชี้ไปที่สิ่งที่เรากำลังดู

- แล้ว พูดคุยกับ Search แบบโต้ตอบได้ทันที

ตัวอย่างการใช้งาน เช่น ถ้ากำลังทำโปรเจกต์แล้วติดปัญหา

- แตะไอคอน “Live” ใน AI Mode หรือ Google Lens

- เปิดกล้อง และถามคำถามได้เลย

Search จะช่วย อธิบายแนวคิดที่ซับซ้อน แนะนำวิธีแก้ไข หรือทางเลือกอื่น ๆ ส่งลิงก์ไปยังแหล่งข้อมูล เช่น เว็บไซต์ วิดีโอ ฟอรั่ม และอื่น ๆ ให้ศึกษาเพิ่มเติม

โมเดลอัจฉริยะที่สุดของ Google : Gemini 2.5

Google ยังคงเดินหน้าอย่างต่อเนื่องในการพัฒนาโมเดล AI ให้ฉลาดและทรงพลังยิ่งขึ้น โดยในเวอร์ชันล่าสุด Gemini 2.5 มีให้เลือกใช้งาน 2 รุ่นหลัก ได้แก่

- Gemini 2.5 Flash

- Gemini 2.5 Pro

1.Gemini 2.5 Flash : เร็ว คุ้มค่า และฉลาดขึ้น

Gemini 2.5 Flash เป็นโมเดลที่มีความเร็วสูง ใช้งานต้นทุนต่ำ และได้รับความนิยมอย่างมากในหมู่นักพัฒนา โดยรุ่นใหม่นี้ได้รับการปรับปรุงแบบรอบด้าน:

- เก่งขึ้นในหลายด้าน ไม่ว่าจะเป็นตรรกะการคิด (reasoning), การประมวลผลหลายรูปแบบ (multimodality), การเขียนโค้ด และการจัดการข้อมูลขนาดใหญ่ (long context)

- ประสิทธิภาพสูงเป็นอันดับ 2 บนตารางคะแนน LMArena เป็นรองเพียงแค่รุ่นพี่ของมันเองคือ Gemini 2.5 Pro

2.Gemini 2.5 Pro: อัปเกรดความสามารถด้านเหตุผลด้วย Deep Think

Google ยังผลักดันขีดจำกัดของ Gemini 2.5 Pro ให้ไปไกลยิ่งขึ้น ด้วยการเพิ่มโหมดใหม่ชื่อว่า Deep Think

- เป็นโหมดที่พัฒนาเพื่อการคิดวิเคราะห์ที่ลึกซึ้งยิ่งขึ้น

- ใช้เทคนิคการคิดขั้นสูงแบบ ขนาน (parallel thinking) และงานวิจัยล่าสุดในด้าน AI reasoning

ผลที่ได้คือโมเดลที่ เข้าใจเรื่องซับซ้อนได้ดีขึ้น วิเคราะห์ได้แม่นยำขึ้น และเหมาะกับการใช้งานที่ต้องการความชาญฉลาดระดับสูง

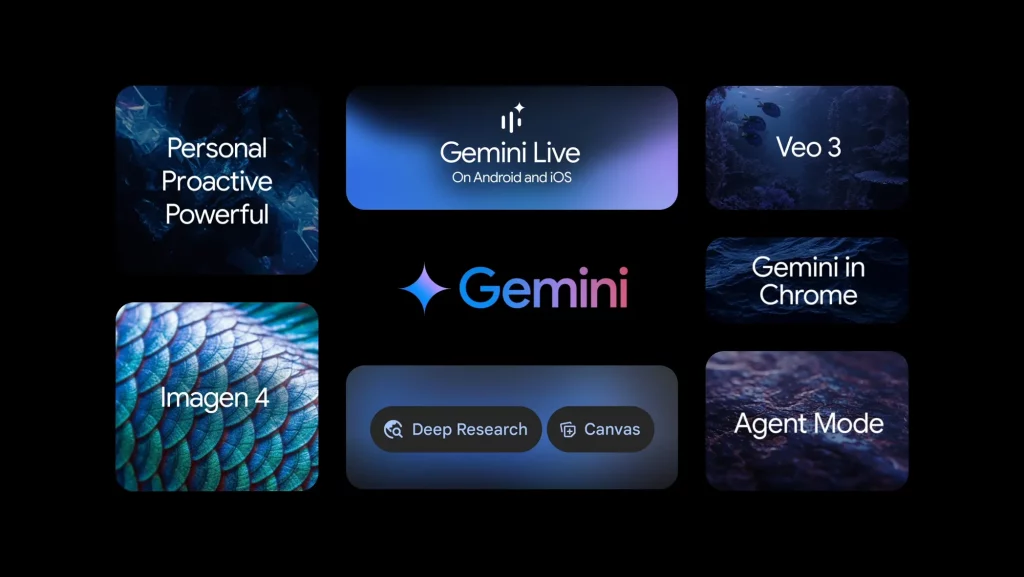

Gemini App ยุคใหม่ : ส่วนตัวมากขึ้น ฉลาดขึ้น และทำได้มากกว่าเดิม

Google กำลังยกระดับแอป Gemini ให้กลายเป็นผู้ช่วย AI ที่ ตอบโจทย์เฉพาะตัวมากขึ้น ทำงานเชิงรุกได้ และทรงพลังยิ่งกว่าเดิม โดยมีการพัฒนาใหม่ ๆ ที่น่าตื่นเต้นหลายด้าน ดังนี้

Deep Research ที่เข้าใจเรามากขึ้น

ฟีเจอร์ Deep Research หรือการวิจัยเชิงลึกด้วย AI จะสามารถใช้ข้อมูลของเราเอง เพื่อสร้างรายงานหรือข้อมูลวิเคราะห์แบบเฉพาะตัวได้ โดยทำงานดังนี้

- อัปโหลดไฟล์ของเรา เพื่อให้ AI ใช้ประกอบการวิเคราะห์

- ในอนาคตอันใกล้ จะสามารถ เชื่อมต่อกับ Google Drive และ Gmail ได้โดยตรง เพื่อให้ Gemini ดึงข้อมูลที่เกี่ยวข้องมาใช้งานได้สะดวกและแม่นยำยิ่งขึ้น

สร้างสื่อโต้ตอบได้ในคลิกเดียวด้วย Canvas

Gemini ถูกผสานเข้ากับ Canvas เพื่อให้สามารถสร้างสื่อสร้างสรรค์ได้ทันที เช่น:

- อินโฟกราฟิก แบบไดนามิก

- แบบทดสอบ (quizzes) สำหรับสื่อการเรียนรู้หรือสื่อสารข้อมูล

- แม้แต่ พอดแคสต์หลายภาษา ได้เพียงคลิกเดียว

นอกจากนี้ ยังมีการใช้งานที่เรียกว่า vibe coding คือการเขียนแอปง่าย ๆ โดย แค่คุยกับ Gemini แล้วมันจะช่วยเราสร้างแอปที่ใช้งานได้จริงแบบอัตโนมัติ

Gemini Live : แชร์กล้องและหน้าจอได้ฟรี

ฟีเจอร์ยอดนิยมอย่าง Gemini Live ที่ให้ผู้ใช้แชร์กล้องหรือหน้าจอให้ Gemini ช่วยดูและวิเคราะห์แบบเรียลไทม์ ขยายการใช้งานให้กว้างขึ้น:

- ใช้งานได้ฟรี สำหรับทุกคน ทั้งผู้ใช้ Android และ iOS

- และในอนาคตอันใกล้ จะสามารถ เชื่อมต่อกับแอป Google ที่เราใช้งานอยู่ เช่น Docs, Calendar, Maps เพื่อให้ความช่วยเหลือของ AI ลื่นไหลและเป็นธรรมชาติยิ่งขึ้น

Gemini App กำลังกลายเป็นมากกว่าแค่แชทบอท มันคือผู้ช่วยส่วนตัวที่ทำงาน วิเคราะห์ สร้างสรรค์ และเรียนรู้จากเราอย่างต่อเนื่อง

เปิดตัว AI สร้างภาพสร้างวิดีโอและเครื่องมือใหม่ : Veo 3, Imagen 4, Flow

Google กำลังผลักดันขอบเขตของ Generative Media หรือสื่อที่สร้างขึ้นด้วย AI ไปอีกขั้น ด้วยการเปิดตัวโมเดลใหม่ล่าสุด ทั้งด้านวิดีโอและภาพ

Veo 3: โมเดลสร้างวิดีโออัจฉริยะ พร้อมเสียงในตัว

Veo 3 คือโมเดลสร้างวิดีโอระดับสูงตัวล่าสุดจาก Google ที่มีความสามารถ ดังนี้

- สร้างวิดีโอ คุณภาพระดับภาพยนตร์

- และที่สำคัญ สร้างเสียง (audio) ประกอบได้เองในตัว อย่างเป็นธรรมชาติ

- พร้อมให้บริการแล้วสำหรับสมาชิก Google AI Ultra ในสหรัฐอเมริกาใน แอป Gemini และใน Flow นอกจากนี้ ยังพร้อมให้บริการสำหรับผู้ใช้ระดับองค์กรใน Vertex AI

Imagen 4 : โมเดลสร้างภาพที่ดีที่สุดของ Google

Google ยังเปิดตัว Imagen 4 โมเดลสร้างภาพ (image generation) ที่ล้ำหน้าที่สุดในขณะนี้

- ภาพที่ได้มีความละเอียดและสมจริง ความละเอียดสูงสุดถึง 2K

- สามารถสร้างภาพในอัตราส่วนภาพต่างๆ

- รองรับการสื่อสารอารมณ์ รายละเอียด และองค์ประกอบภาพในระดับที่แม่นยำกว่าเดิม

- เร็วกว่า Imagen 3 ถึง 10 เท่า

- พร้อมใช้งานแล้ววันนี้ใน แอป Gemini, Whisk, Vertex AI และในรูปแบบ Slides, Vids, Docs และอื่นๆ ใน Workspace

Flow : เครื่องมือใหม่สำหรับนักทำหนัง

Google ยังแนะนำเครื่องมือใหม่ชื่อว่า Flow สำหรับผู้สร้างภาพยนตร์และนักคอนเทนต์

- สร้างคลิปวิดีโอที่มีความรู้สึกแบบ “หนังจริง”

- และสามารถ ขยายคลิปสั้นให้กลายเป็นฉากที่ยาวขึ้น ได้อย่างราบรื่น

- เปิดให้บริการแล้ววันนี้ สำหรับสมาชิกแผน Google AI Pro และ Ultra ในสหรัฐอเมริกา และจะเปิดให้บริการในประเทศอื่นๆ เร็วๆ นี้

Google AI Ultra แพ็กเกจใหม่ แพงสุด ครบสุด 9,400 บาท/เดือน

แพ็กเกจ Google AI Ultra ที่รวมบริการด้าน AI และความสามารถใหม่ล่าสุดพร้อมโมเดลตัวโหด ตอนนี้ในไทยยังซื้อไม่ได้

ดูรายละเอียดแพ็กเกจได้ที่ >> เปิดตัว Google AI Ultra แพ็กเกจตัวท็อป

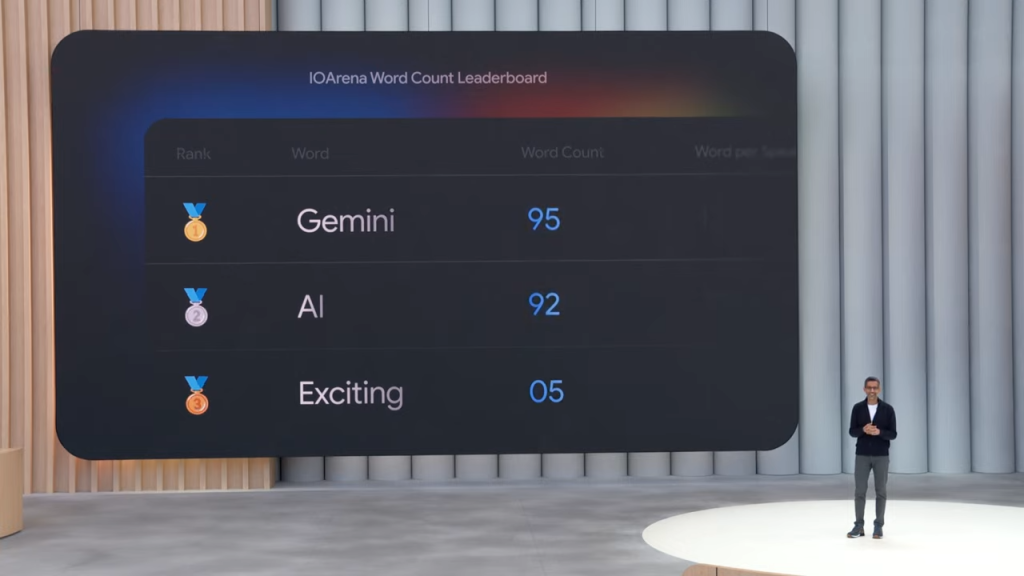

ปิดท้ายงานแบบฮาๆ แอบแซวตัวเองเบาๆ

Sundar Pichai ซีอีโอของ Google กล่าวปิดท้ายงาน Google I/O 2025 แล้วยังได้ทำอินโฟนับคำ ว่าในงาน พูดคำว่า Gemini, AI, Exciting ไปทั้งหมดกี่คำ ผลก็ตามนี้เลย

3 months ago

60

3 months ago

60

.jpg)

English (US) ·

English (US) ·